Một trong những phần làm cho tính năng ChatGPT trở nên phong phú là mô hình ngôn ngữ khổng lồ đằng sau nó. Nếu GPT-3 có quy mô lên tới 175 tỷ tham số thì mô hình ngôn ngữ GPT-4 mới ra mắt được cho là có quy mô hơn 1.000 tỷ tham số và được coi là mô hình ngôn ngữ lớn nhất từ trước đến nay. cho đến thời điểm hiện tại.

Nhưng vào giữa tháng 4, chính Giám đốc điều hành OpenAI Sam Altman đã cảnh báo rằng thời đại của những mô hình ngôn ngữ lớn này đã kết thúc, mặc dù vẫn chưa rõ điều gì sẽ thay thế chúng trong tương lai. tương lai.

Tại một sự kiện do MIT tổ chức, ông Sam Altman cho biết: “Tôi nghĩ rằng chúng ta đã kết thúc thời đại mà mọi người đều đổ xô vào những mô hình siêu khổng lồ. Chúng tôi sẽ làm cho chúng tốt hơn theo một cách khác.”

Giám đốc điều hành OpenAI, Sam Altman. ảnh internet

Tuyên bố của Altman đại diện cho một bước ngoặt bất ngờ trong cuộc đua phát triển và triển khai các thuật toán AI mới. Kể từ khi OpenAI ra mắt ChatGPT vào tháng 11 năm ngoái, Microsoft đã sử dụng công nghệ cơ bản của mình để triển khai chatbot trong công cụ tìm kiếm Bing và thúc đẩy Google làm điều tương tự khi tung ra chatbot. Thi nhân. Nhiều người cũng đang gấp rút thử nghiệm loại AI mới này để hoàn thành công việc hoặc các nhiệm vụ cá nhân.

Tuyên bố của Altman gợi ý rằng GPT-4 có thể là bản nâng cấp lớn cuối cùng cho chiến lược đã được OpenAI triển khai trong vài năm qua – làm cho các mô hình ngày càng lớn hơn và tải ngày càng nhiều dữ liệu hơn. nhiều vật chất hơn.

Vào năm 2019, OpenAI đã giới thiệu mô hình ngôn ngữ đầu tiên của mình, GPT-2. Ở quy mô lớn nhất, GPT-2 có khoảng 1,5 tỷ tham số với 40 GB văn bản. Rồi đến năm 2020, GPT-3 ra mắt với 175 tỷ thông số và có dung lượng lưu trữ lên tới 800GB.

GPT-4, mô hình ngôn ngữ tự nhiên được cho là có kích thước lớn nhất cho đến nay. ảnh internet

Gần đây nhất là mô hình GPT-4 – mặc dù OpenAI không tiết lộ kích thước chính xác của mô hình này nhưng nhiều chuyên gia trong ngành dự đoán rằng nó có thể lên tới 1 nghìn tỷ tham số, lớn nhất từ trước đến nay. Hiện nay. Nhưng với tuyên bố nói trên của CEO OpenAI, cuộc đua tạo ra các mô hình ngôn ngữ quy mô lớn dường như đã ngã ngũ.

Lý do đằng sau tuyên bố đột ngột này

Đầu tiên là chi phí. Cũng tại sự kiện MIT nói trên, khi được hỏi liệu đào tạo mẫu GPT-4 có tiêu tốn tới 100 triệu USD hay không, ông Altman trả lời: “Nó còn hơn thế nữa.” Kích thước mô hình lớn hơn, đồng nghĩa với dữ liệu cần xử lý cũng lớn hơn, dẫn đến chi phí tính toán xử lý dữ liệu ngày càng tăng.

Chưa kể chi phí chạy các mô hình này khi trả lời các truy vấn của người dùng. Mặc dù OpenAI và Microsoft không tiết lộ con số cụ thể nhưng nhiều chuyên gia trong ngành cho rằng hiện ChatGPT đang chạy tốn gần 1 triệu USD mỗi ngày. Con số này có thể tăng cao hơn nữa khi số lượng người dùng chatbot này tiếp tục tăng.

Chi phí chạy ChatGPT có thể lên tới hơn 700.000 USD mỗi ngày.

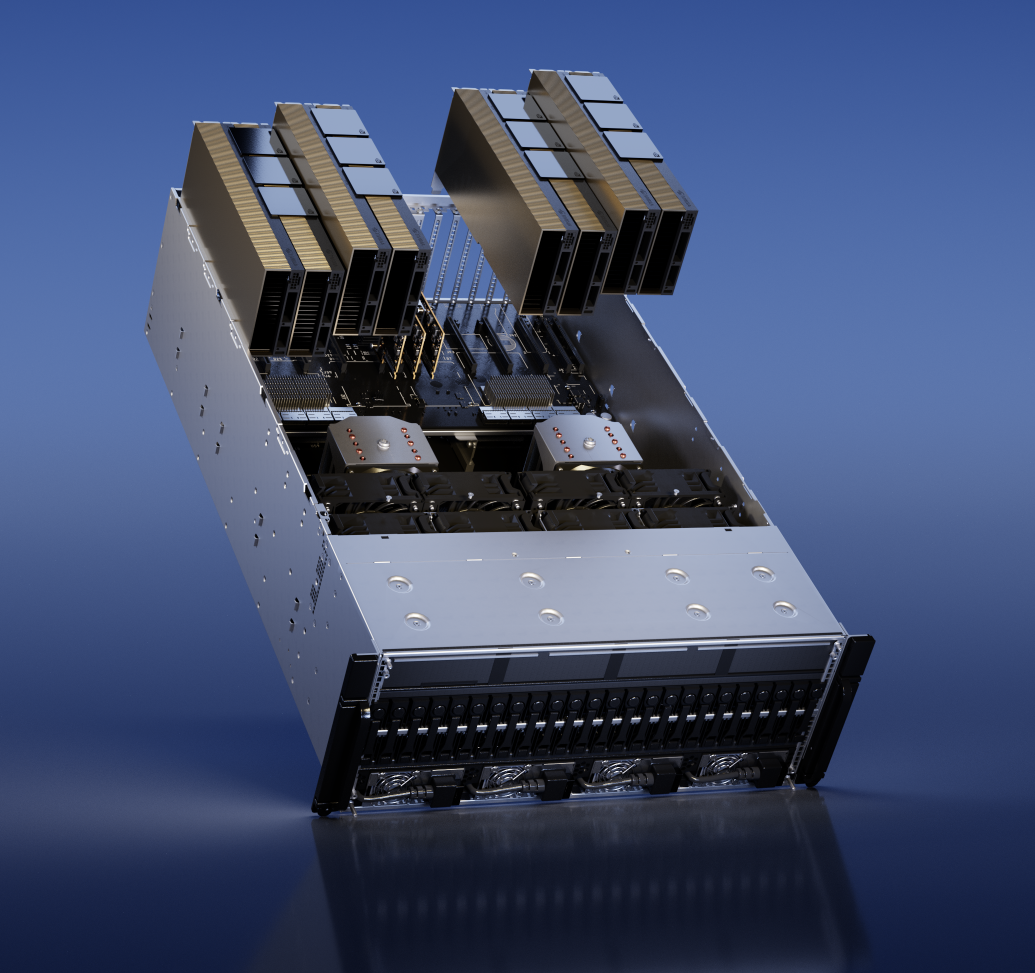

Một phần lý do cho chi phí khổng lồ này đến từ chi phí cao ngất trời của một thành phần quan trọng: GPU AI. Ví dụ, để huấn luyện ChatGPT, các báo cáo cho biết cần tới hơn 10.000 GPU Nvidia A100 với chi phí lên tới 10.000 USD cho mỗi thiết bị. Thậm chí, để vận hành ChatGPT, số lượng GPU cần thiết còn lớn hơn, kéo theo chi phí cũng lớn hơn.

Mới đây, Nvidia tiếp tục ra mắt dòng GPU H100 được thiết kế dành riêng cho xử lý các tác vụ AI và điện toán hiệu năng cao. Nhưng giá thành của linh kiện này còn đắt hơn khi lên tới 30.000 USD cho mỗi sản phẩm, và nếu mua lẻ trên eBay thì cái giá phải trả còn cao hơn. Các mô hình lớn hơn sẽ yêu cầu nhiều GPU hơn để đào tạo và xử lý, dẫn đến chi phí cao hơn.

Thậm chí một cuộc khủng hoảng nguồn cung của loại GPU này có thể xảy ra khi các thành phần này không có sẵn cho đại chúng. Giá thành cao, chỉ dành cho một số nhóm khách hàng nhất định nên GPU sẽ hiếm khi có sẵn để đáp ứng nhu cầu khách hàng lớn. Mới đây, ông Elon Musk cũng xác nhận sẽ mua 10.000 GPU để phát triển một công ty AI mới có tên là X.ai. Nhưng nhiều chuyên gia trong ngành cho rằng Musk có thể phải đợi hàng tháng trời mới có đủ số lượng GPU mà mình yêu cầu.

GPU H100 HVL của Nvidia, GPU dành riêng cho AI và các tác vụ điện toán hiệu suất cao. ảnh internet

Ngoài ra, trong tài liệu mô tả GPT-4, OpenAI cũng ước tính rằng hiệu quả từ việc nhân rộng kích thước mô hình đang giảm đi – nghĩa là ngay cả khi kích thước khối dữ liệu tăng lên thì hiệu quả xử lý cũng không tăng. tăng tương ứng. Altman cho biết cũng có những giới hạn vật lý đối với số lượng trung tâm dữ liệu mà một công ty có thể xây dựng và tốc độ xây dựng chúng.

Nick Frost, đồng sáng lập Cohere, người từng làm việc về AI tại Google cũng đồng tình với nhận định của Sam Altman. Ông cũng tin rằng sự tiến bộ của Transformer, loại mô hình học máy ở trung tâm của GPT-4 và các mô hình AI đối thủ, không chỉ phụ thuộc vào quy mô của nó, mà còn phụ thuộc vào các yếu tố khác, bao gồm thiết kế, kiến trúc hoặc khả năng tinh chỉnh các mô hình cũng như phản hồi từ huấn luyện viên…

Link nguồn: https://cafef.vn/la-nen-tang-cho-tri-tue-cua-chatgpt-nhung-openai-lai-tuyen-bo-thoi-cua-cac-mo-hinh-ai-khong-lo-da-ket-thuc-188230505160015127.chn